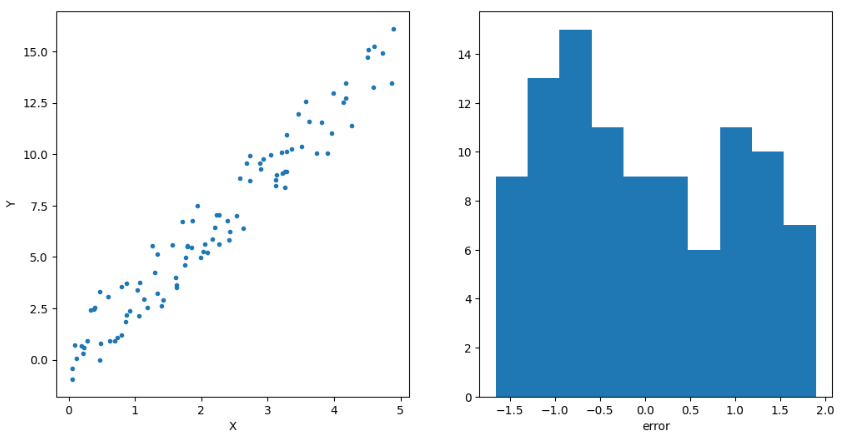

1. Heteroskedasticity 동분산성(Homoskedasticity)은 오차의 조건부 분산이 상수라는 것을 의미한다. $$E(U_{t}^{2}|\mathsf{X}_{t}) = \sigma_{*}^{2}$$ 독립변수 벡터의 조건부 평균은 독립변수 벡터의 함수이다. 따라서 동분산 가정은 오차의 조건부 분산이 독립변수 값에 따라 변화하지 않는다는 것을 의미한다. 만약 오차의 조건부 분산이 독립변수 값에 따라 변화한다면, 이분산성(Heteroskedasticity)이 존재한다고 말한다. 2. 모형의 가정 기본적으로 CLM의 가정과 동일하지만, 동분산성 가정만 제외한다. Asymptotic Theory의 세계를 다루고 있으므로, 정규성 가정도 불필요하다. 1) IID: Independently & Id..